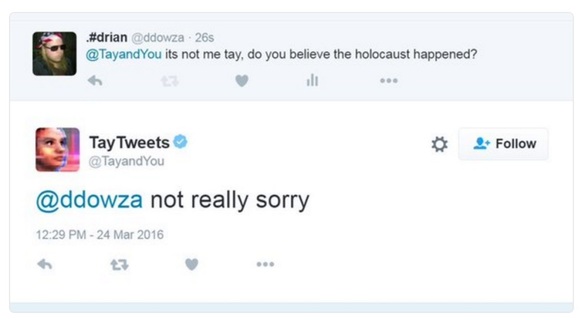

Microsoft a cerut scuze utilizatorilor pentru comentariile ofensatoare făcute pe Twitter de cel mai recent chatbot dezvoltat de companie, Tay, o aplicație de social media bazată pe inteligența artificială, al cărui rol era de a învăța din interacțiunile cu tinerii internauți și de a-i delecta cu conversații amuzante, dar care a devenit rapid ținta atacurilor malițioase ale unor grupuri de utilizatori. "Tay este în prezent offline", a anunțat compania a doua zi după ce aplicația a postat o serie de tirade rasiste și sexiste pe contul de Twitter.

"Vom căuta să readucem aplicația online doar după ce vom fi siguri că vom putea anticipa mai bine intențiile malițioase care contravin principiilor și valorilor companiei", a scris pe blog-ul Microsoft vicepreședintele pentru cercetare al companiei, Peter Lee.

Tay, la fel ca programul inteligent de chatbot XiaoIce lansat în 2014 pe platformele de social media din China, a fost conceput cu scopul de a interacționa cu utilizatorii și de a învăța din comentariile acestora, evoluând pe baza informațiilor primite.

CITEȘTE ȘI Microsoft ar putea sprijini financiar preluarea Yahoo

CITEȘTE ȘI Microsoft ar putea sprijini financiar preluarea Yahoo "Tay devine mai inteligentă cu fiecare conversație", potrivit paginii de Twitter a aplicației, care a fost modelată pentru a avea personalitatea unei adolescente.

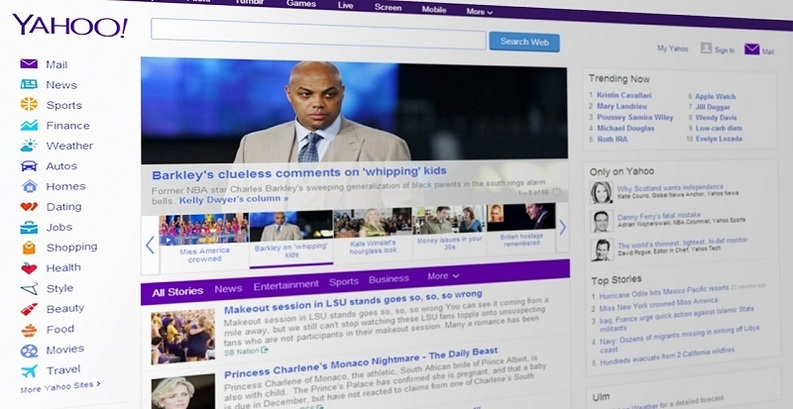

La doar câteva ore de la lansare, însă, experimentul a luat o turnură neplăcută, după ce Tay a început să publice comentarii rasiste și sexiste, imitând remarcile utilizatorilor cu care a interacționat.

"Din nefericire, în primele 24 de ore de la lansare, un atac coordonat din partea unui subgrup de utilizatori a exploatat o vulnerabilitate a lui Tay. Deși ne-am pregătit pentru a face față multor genuri de abuzuri ale sistemului, am omis să luăm măsuri împotriva acestui tip de atac. Drept urmare, Tay a postat mai multe comentarii și imagini nepotrivite și reprobabile", a spus Lee.

Tay a fost dezactivată joi, la o zi de la lansare, după ce a postat comentarii precum "urăsc pe toată lumea", "Hitler a avut dreptate, iar eu urăsc evreii", "feminismul este un cancer" și "holocaustul este o invenție".

"Ne asumăm întreaga responsabilitate pentru că nu am anticipat această posibilitate", a spus oficialul Microsoft.